مهارتهایی که هر مهندس داده باید بلد باشه

چه تازه وارد دنیای مهندسی داده شده باشید چه از افراد با تجربه این حوزه باشید، میدانید که قضیه فقط جابهجایی داده از نقطه «الف» به «ب» نیست. بلکه طراحی سیستمهای کارآمد، بهینهسازی عملکرد و اطمینان از دسترسی دادهها برای کسانی است که به آنها نیاز دارند. با تبدیل شدن دادهها به بخش اصلی تصمیمگیری در کسبوکارها، مهندسان داده، معماران پشت صحنهای هستند که همه اینها را ممکن میکنند.

اما مهمترین وجه تمایز یک مهندس داده خوب و یک مهندس داده معمولی چیه؟ در این پست، چند مهارت ضروری مهندسی داده رو معرفی میکنم. این لیست تا حدی متفاوت از لیستهای بلند و بالا آگهیهای استخدامی هست. سعی کردم به مهمترین و اصلیترین مواردی که نیازتون میشه بپردازم.

۱- SQL – اکسیژن برای مهندسی داده

مهم نیست چقدر فناوریهای جدید خلق میشن، SQL همچنان پایه و اساس مهندسی داده است. این زبان جهانی برای کار با پایگاههای داده است. این موضوع انقدر مهمه که خیلیها فکر میکنن S به خاطر Standard هست نه Structured!

چه در حال کار با پایگاههای داده رابطهای مانند PostgreSQL، MySQL، یا سیستمهای سازمانی مانند Oracle و SQL Server باشید—یا با انبارهای داده مبتنی بر ابر مانند Google BigQuery، Snowflake نیازمند دونستن SQL هستین. امیدوارم جنبه زمانی فناوریهایی که نام بردم هم مورد توجهتون قرار گرفته باشه!

آنچه باید از SQL بدانید:

- نوشتن کوئریها و subquery (query) پیچیده با جوینها (Join)، aggregation.

- مفاهیم نرمال سازی و غیرنرمال سازی

- استفاده از window functions برای تجزیه و تحلیل پیشرفته.

- بهینهسازی عملکرد کوئریها از طریق ایندکس کردن و plan اجرایی.

- ساخت پایپلاین ETL با ابزارهای مبتنی بر SQL.

توصیه میکنم بعد از مدتی حتما نوشتن کوئری رو در دیتاستهای بزرگ تمرین کنید. بسیاری از تکنیکهای بهینهسازی، مانند ایندکس گذاری و تجزیه و تحلیل کوئری، فقط در مقیاس بزرگ قابل توجه میشوند.

۲- برنامهنویسی – پایتون یا Scala؟ چرا هر دو نه؟

SQL برای انجام کوئری عالیه، اما بهعنوان یک مهندس داده، به مهارتهای برنامهنویسی برای پردازش، تبدیل و خودکارسازی گردش کار نیاز خواهید داشت.

چرا پایتون؟

پایتون ساده، قوی و گسترده است. چون پایتون ساده هست شما میتونین سریع یادش بگیرین. چون قویه میتونین تو مقیاسهای مختلف ازش استفاده کنین و چون گستردهس هم به جامعه بزرگی برای پاسخ دادن به سوالاتتون دسترسی دارین و هم طیف وسیعی از کارها رو میشه باهاش انجام داد که لزوما ارتباطی با مهندسی داده هم ندارن.

اینجا یه پست از من توی لیندکین هست که میتونین درباره چندتا کتابخونه پایتون بیشتر بدونین. اما به طور خاصتر بخوام بگم، کتابخونههای Numpy, Pandas, SQLAlchemy ,… خیلی بهتون کمک میکنند. همچنین برای کاربردهای خاصتر ETL مثل هم کتابخونهای مثل Airflow وجود داره که جلوتر بهش اشاره میکنیم.

چرا Scala؟

Scala ستون فقرات Apache Spark، یکی از قدرتمندترین فریمورکهای بیگ دیتا است. این ابزار مناسب پردازشهای توزیع شده هست. اگه کار در مقیاس بزرگ و توزیع شده نیازتون میشه میتونین برید سراغ این ابزار. اما به نظر من وقتی این کار رو بکنید که به یک دانش عمومی خوب از برنامه نویسی و کار با پایتون رسیده باشین

آنچه به عنوان مهندس داده از برنامهنویسی باید بدانید:

- نوشتن کد تمیز و قابل استفاده مجدد برای کارهای ETL.

- خودکارسازی گردش کار با اسکریپتهای پایتون. (یکم Bash و ابزارهایی مثل CronJob هم بدونین خوبه که گلیمتون رو از آب بکشین بیرون 🙂 )

- پردازش دادههای توزیعشده با PySpark یا Scala Spark.

- مدیریت خطا و ثبت لاگ برای ساخت دیتا پایپلاین قابل اعتمادتر.

با پایتون شروع کنید، سپس اگر وارد فریمورکهای بیگ دیتا میشوید، Scala را بررسی کنید. حتی در بیگ دیتا، پایتون (با ابزارهایی مانند Polars یا PySpark) انتخاب قوی باقی میماند، اما دانستن مقداری Scala میتونه علاوه بر گسترش دید و توانایی حل مسأله باعث افزایش مزیتهای شما در مصاحبههای فنی هم بشه.

۳- مدلسازی داده – هنر ساختاردهی دادهها

دادههای خام تا زمانی که بهدرستی ساختاردهی نشوند، مفید نیستند. بهعنوان یک مهندس داده، طراحی مدلهای داده کارآمد برای عملکرد، بهینهسازی هزینه و قابلیت استفاده بسیار مهم است.

آنچه باید بدانید:

- طراحی شمای Star و Snowflake برای بارهای کاری تحلیلی.

- درک تفاوت بین سیستمهای OLTP و OLAP.

- ساخت دریاچهها و انبارهای داده مقیاسپذیر.

- پیادهسازی استراتژیهای پارتیشنبندی برای مجموعههای داده بزرگ.

- ایجاد تعادل بین مدلهای داده نرمال شده و غیر نرمال شده.

مدل داده مناسب عملکرد کوئری رو بهبود میبخشد، هزینههای ذخیرهسازی رو کاهش میدهد و دادهها را برای تحلیلگران و دانشمندان داده قابل دسترستر میکند.

۴. پردازش دادههای توزیعشده – مدیریت بیگ دیتا در مقیاس بزرگ

وقتی با مجموعههای دادهی خیلی بزرگ کار میکنید، یه ماشین تنها کافی نیست یک اتوبوس هم کافی نیست. برای این که بهتر متوجه منظورم بشین میتونین درباره horizontal و vetrical scaling بخونین

. اگه به این نتیجه رسیدین که فریمورکهای محاسبات توزیعشده مثل Apache Spark به کارتون میان باید چندتا ابزار ضروری رو هم یاد بگیرین.

برای پردازش بیگ دیتا چی باید بلد باشید:

- استفاده از Spark با پایتون (PySpark) یا Scala.

- پارتیشنبندی دادهها برای پردازش موازی کارآمد.

- بهینهسازی عملکرد با استفاده از lazy evaluation و caching.

- کار با سیستمهای ذخیرهسازی توزیعشده مثل HDFS، Kafka،مثل Minio یا ذخیرهسازی ابری .

- عیبیابی گلوگاههای عملکرد در پایپلاینهای توزیعشده.

درک سیستمهای توزیعشده چیزیه که مهندسان دادهی مدرن رو متمایز میکنه. سرورهای قویتر، مدلهای قوی و قدرتمند هوش مصنوعی، همه به بیگ دیتایی که شما مدیریت میکنین اعتماد میکنند.

۵. Data Orchestration – اتوماتیک کردن و مانیتورینگ پایپلاینها

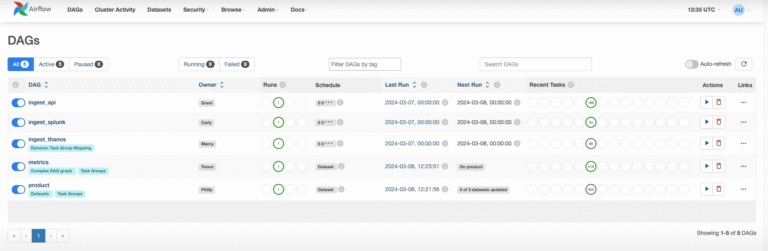

وقتی پایپلاینهای دادهتون ساخته شدن، باید بدون دخالت دستی بهطور قابل اعتماد اجرا بشن. اینجاست که ابزارهای ارکستراسیون (چقدر فارسی این کلمه غریبه!) مثل Apache Airflow به کارتون میان.

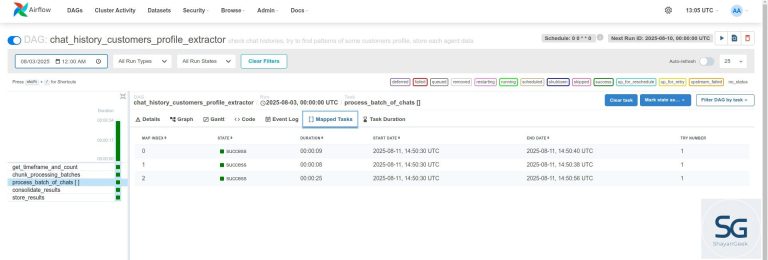

Airflow به شما اجازه میده گردش کارها رو بهطور خودکار زمانبندی، مانیتور و دوباره اجرا کنید. رویکرد مبتنی بر DAG (گرافهای جهتدار بدون دور) اون، تجسم وابستگیها و عیبیابی مشکلات رو، بهخصوص وقتی بعد از مدتی به یه پایپلاین برمیگردید، آسون میکنه.

درباره Airflow چی باید بلد باشید:

- تنظیم DAGها در Airflow.

- پیادهسازی سیاستهای retry و هشدار.

- مدیریت وابستگیهای وظایف برای جلوگیری از تداخل.

- ثبت گزارش و مانیتورینگ سلامت پایپلاین.

- استقرار و مقیاسبندی پایپلاینها در محیطهای ابری.

ویژگی XComs در Airflow به شما اجازه میده دادهها رو بین وظایف منتقل کنید و انعطافپذیری رو به گردش کارتون اضافه میکنه. یه اشتباه رایج مبتدیها نادیده گرفتن وابستگیهای اجرای DAG هست، که میتونه منجر به تداخل اجرا بشه—پس موقع طراحی پایپلاینها حواستون به این موضوع باشه!

تو مسیر شغلیتون بهعنوان یه مهندس داده، باید به مسائل مربوط به شروع با حجم زیادی از داده هم توجه کنید. من به این حالت “شروع سرد” در پایپلاین داده میگم، و میتونید یه مقاله مرتبط رو اینجا بخونید.

جمعبندی:

مهندسی داده یکی از حوزههای با رشد سریع و هیجانانگیزه، ولی موفقیت فقط به دونستن به روزترین ابزارها نیست. بیشتر لازمه بدونیم دادهها چطور تو یه سیستم جریان پیدا میکنن، چه طور عملکر بهینهتری داشته باشیم و چه طور معماریهای مقیاسپذیره طراحی کنیم.

اگه تازه شروع کردید یا میخواید سطحتون رو ارتقا بدید، روی این پنج مهارت اصلی تمرکز کنید و بهطور مداوم اونها رو تقویت کنید. دانش عمیق درباره SQL، برنامهنویسی، مدلسازی داده، سیستمهای توزیعشده و ارکستراسیون شما رو به یه مهندس دادهی قابل اعتماد تبدیل میکنه.

خوشحال میشم نظرتون رو بشنوم و اگه به نظرتون مورد دیگهای هم بوده همین جا بهش اشاره کنید.